三次元物体検出_Tengun-label

- Tengun-label

- 2022年9月6日

- 読了時間: 4分

◉背景

センシング技術が進むお陰て、3Dデータが取りやすくなりました。その中、特にLidarが色々な場面で活躍しています。

2Dデータと比べて、3Dデータはもう一次元の「距離」情報を提供します。それによって、リアル世界を更に深く理解することが可能になる。

3Dデータ+深層学習では、色々なリアル問題を解決しました。

◉三次元点群の応用

Lidarから三次元点群を取得できます。

自動運転(車、ロボット)では、三次元点群+深層学習は重要である。

深層学習により、三次元点群データを自動処理できます。以下のタスクで応用できます:

三次元点群セグメンテーション(PointCloud Segmentation)

三次元物体検出(3D Object Detection)

三次元物体認識・分類(3D Object Classification)

三次元物体追跡(3D Object Tracking)

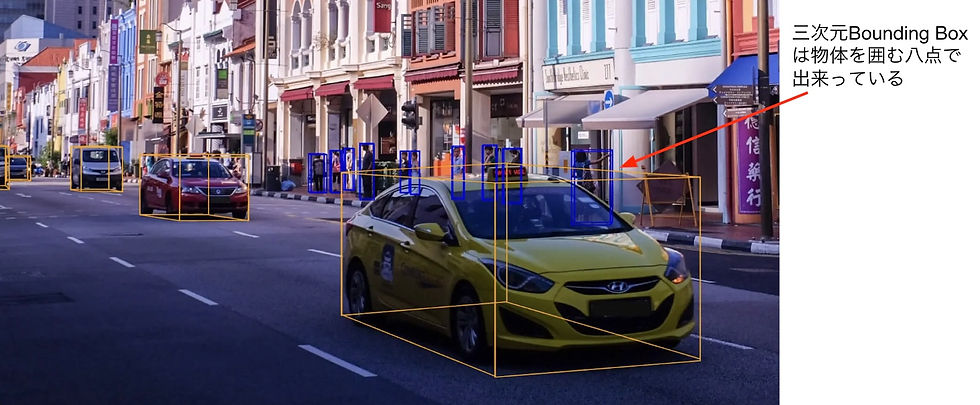

【自動運転の事例:Lidarデータによる物体検出】

【Augment Realityの事例】

【クオリティ分析の事例:設計とリアルを照らし合わせる】

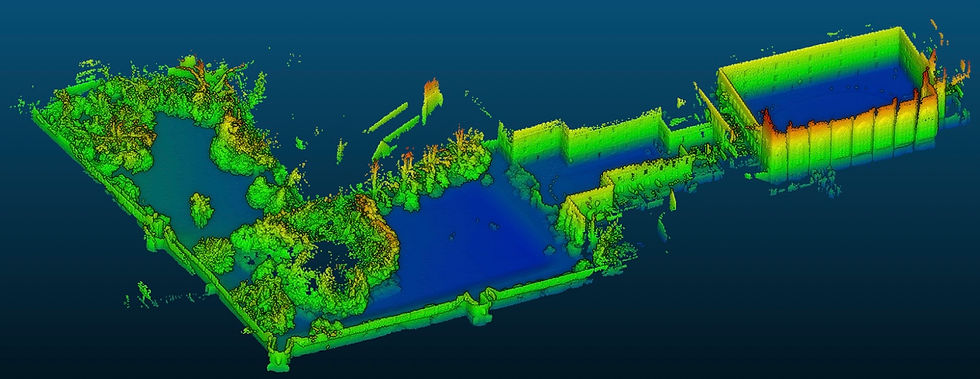

【3D環境再構築の事例:環境を再構築する】

【SLAMの事例:リアルタイムで居場所を計算する】

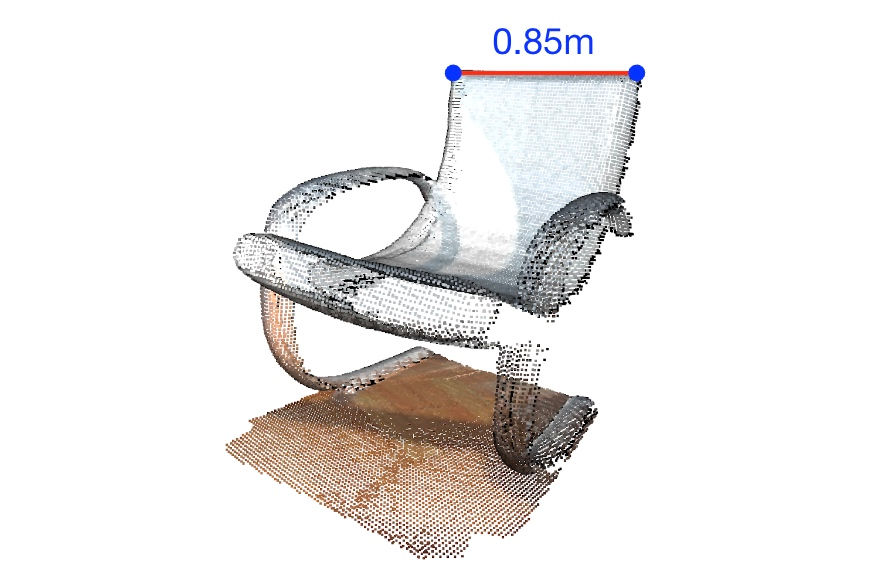

【距離計測の事例:リモートで距離を計測する】

◉三次元点群の応用:三次元物体検出

自動運転をする際に、周囲の物体(車とか)を検出する必要がある。そうすると、車が周囲の環境を”理解”できる。

:手法

車に搭載するセンサーから得るデータを基づいて、3D物体検出を行う

3D物体検出では、オブジェクトの種類、サイズ、距離を検出できる

3D物体検出によって環境を”理解”できると、車が相応の行動を取れる

【物体検出:三次元物体のBounding Boxを検出する】

■車に搭載されるセンサー

CAMERA:RGBデータを取得する為のカメラ

LIDAR:Laserを使って、三次元点群を取得するためのセンサー

RADAR:音声を使って距離を判断するためのセンサー

LIDARは三次元情報を直接提供するので、3D物体検出に役立つ。

CAMERAは2Dデータを提供するが、3D物体検出にとっては、点群ほどストレートではない。

■データを取得するためのセンサー

【三次元物体検出:Model】

点群が取得した後、深層学習で3D物体検出を行う。

3D物体検出深層学習モデルをいくつ紹介いたします。

PointNet

VoxelNet

PointPillars

IA-SSD

BEVFusion

【三次元物体検出:PointNet】

◉PointNetは点群データを直接処理する

■PointNetモデルの処理プロセス

点群をインプットにする

処理しやすく為、Transform Moduleでインプットを変換する

Multilayer perceptron(mlp)層によって、特徴の次元を拡大する

もう一度Transform Moduleで変換する

mlp層とmax pooling層の組み合わせて、結果を絞り出す

◉Transform Module

PointNetは深層学習で三次元データを処理する初めてのマイルストーン

PointNetはTransform moduleによって、点群を適切に変換して処理する(人間が視点を変わって物体を観察すると似ている)

PointNetは点群データを直接利用するので、精度と効率は低い

点群のままでは、表現力が弱い

点の数が多い為、無駄な処理が多い

【三次元物体検出:VoxelNet】

■Voxelを基本単位で点群を処理する

Voxelを使って、空間を区切る

Voxelは内部の点によって、Voxelの特徴を生成する

3D Convolution Neural Network(CNN)で、特徴を処理する

目標のBounding Boxを絞り出す

End-to-End Learning for Point Cloud Based 3D Object Detection (CVPR 2018)

Voxel単位で処理するので、PointNetより効率が高い

Voxelの特徴抽出部分を丁寧に設計した

PointNetと比べて、Transform moduleは使えなくなる

Voxelのサイズはフィクスされるので、点群密度のばらつきが大きいと(例:Lidarデータ)、VoxelNetの精度が落ちる

3D CNNを使うので、処理速度が高くない

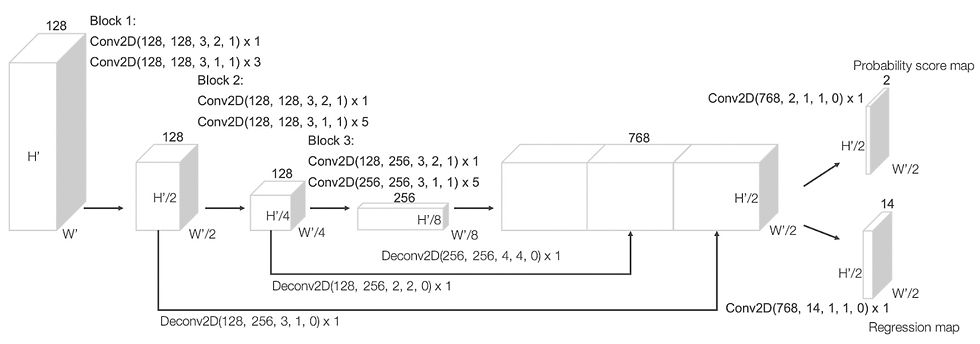

【三次元物体検出:PointPillars】

◉Lidarデータの形はケートと似ている

◉PointPillars:Pillar(細長いVoxel)を基本単位にする

■Pillarsを基本単位で点群を処理する

Pillarsを使って、空間を区切る

Pillarsは内部の点によって、Pillarsの特徴を生成する

2D Convolution Neural Network(CNN)で、特徴を処理する

目標のBounding Boxを絞り出す2D CNNを使うので、処理速度は高い(40FPS以上)

◉2DのPyramid構造を持つNeural Networkを使って処理する

PointPillarsはLidarに対して設計したモデル

2D CNNを使うので、処理速度は高い(40FPS以上)

Lidarデータ上の物体検出の精度が高い

【三次元物体検出:IA-SSD】

■Lidarの点群の中、全ての点は同じく重要ではない

目標オブジェクトの重要度は高い

バックグランドの重要度は低い

■重要度に応じるサンプリングする

重要な点に対して、高い頻度でサンプリングするべき

重要でない点に対して、低い頻度でサンプリングするべき

■提案したサンプリング手法

サンプリングModuleを学習させて、ベストなサンプリングを行う

■提案したサンプリング手法

MLP層で目標クラスに対してを頻度高くサンプリングする

オブジェクト中心に近いほど、サンプリング頻度を高くする

■この手法のメリット

必要な点を多めにサンプリングでき、必要のない点を少なめにサンプリングすることができる

結果:高速且つ高精度で物体検出ができる(80FPS以上)

【三次元物体検出:BEVFusion】

BEVFusion:カメラデータとLidarデータを融合して物体検出を行う

この前の手法はLidarのみ利用したが、自動運転の場合、カメラのデータを利用できる

メリット:情報が増えるので、精度の向上は期待できる

難点:カメラのRGBデータとLidarの点群データの性質は違うので、融合は難しい

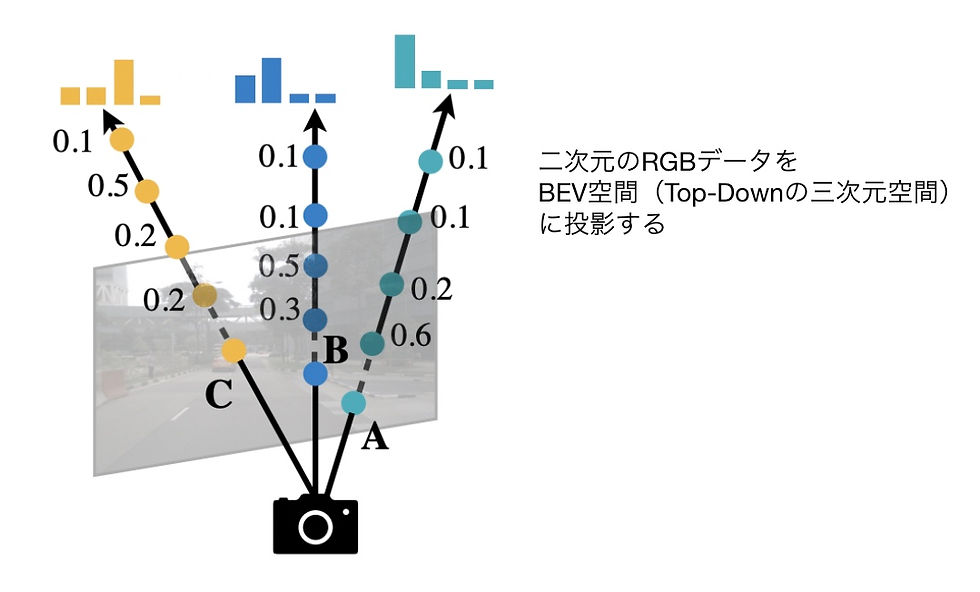

◉BEVFusion:カメラとLidarデータをBEV空間で融合させる

◉BEVFusionモデルの構造

◉カメラデータをBEV空間に投影する

RGB画像と点群の性質が違う、融合は困難である

BEVFusionは一つの融合手法を提案した

BEVFusionはLidarのみの手法より、精度が高い

【お問い合わせ】

AIや3次元画像処理をはじめとした様々なセンシング、データ解析に関するご相談はTengun-labelまでお問い合わせください。

株式会社Tengun-label

本社:東京都新宿区西新宿4-31-3 永谷リヴュール新宿 1014号室

ブランチオフィス:東京都新宿区西新宿6-6-2 新宿国際ビルディング4F コンピュータマインド内

メールアドレス:info@tengun-label.com

TEL:080-5179-4874

Comments